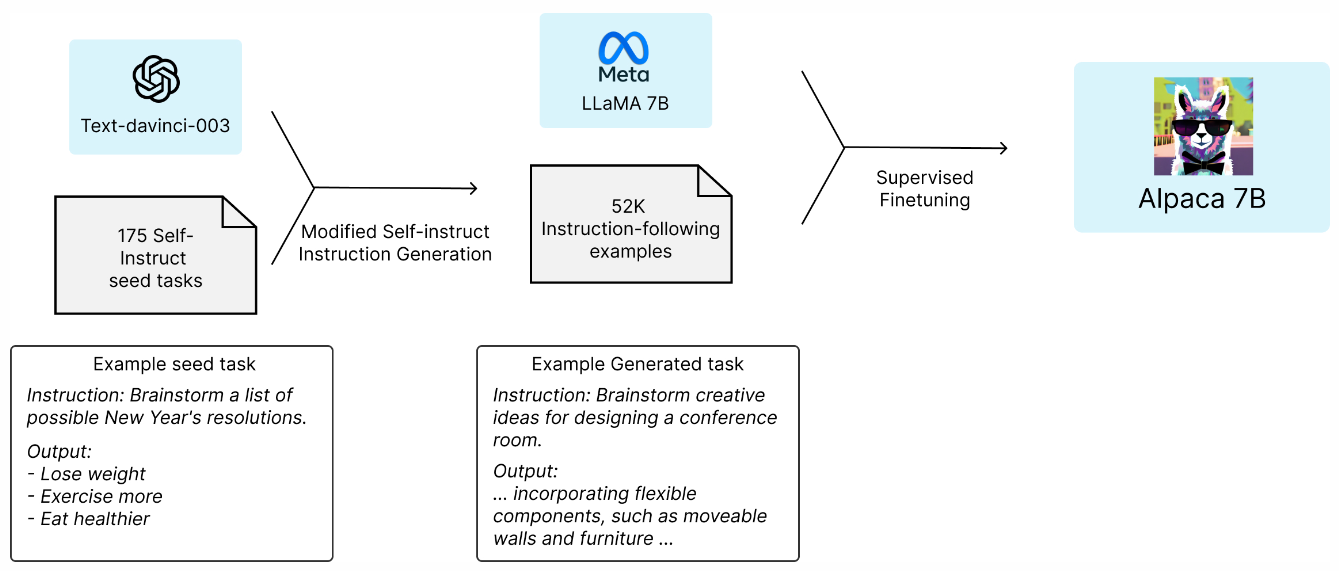

这张图展示了一个用于训练 Alpaca 7B 模型的流程。以下是每个步骤的详细解释:

Text-davinci-003:

- 这是一个预训练的语言模型,可能是 OpenAI 的 GPT-3 模型的一个变种,用于生成初始任务和指令。

175 Self-Instruct Seed Tasks:

- 这些是初始的自我指令任务,包含了175个种子任务。这些任务提供了基本的指令和预期的输出示例。

示例种子任务:

- 指令:列出可能的新年决心。

- 输出:减肥、更多锻炼、吃得更健康。

Modified Self-instruct Instruction Generation:

- 使用 Text-davinci-003 模型和175个种子任务,生成了更多的指令任务。这些新生成的任务被称为“修改后的自我指令任务”。

示例生成任务:

- 指令:为设计一个会议室提供创意。

- 输出:包括灵活的组件,如可移动的墙壁和家具。

Meta LLaMA 7B:

- 这是一个由 Meta(Facebook)开发的预训练语言模型,具有70亿参数(7B)。这个模型作为基础模型,用于进一步的微调。

52K Instruction-following Examples:

- 使用上一步生成的指令任务,创建了52,000个指令跟随示例。这些示例包含了指令和相应的输出,用于训练模型。

Supervised Finetuning:

- 使用生成的52K指令跟随示例,对 Meta LLaMA 7B 模型进行监督微调。监督微调是一种训练方法,其中模型通过学习输入和输出对来优化其性能。

Alpaca 7B:

- 最终,经过监督微调的模型被称为 Alpaca 7B。这个模型在指令跟随任务上具有更好的性能和能力。

总结

- 起点:使用 Text-davinci-003 和 175 个种子任务生成大量指令跟随示例。

- 基础模型:Meta LLaMA 7B。

- 训练:通过监督微调(使用52K指令跟随示例)优化基础模型。

- 结果:得到一个增强的模型 Alpaca 7B,该模型在指令跟随任务上表现更好。

这个流程展示了如何通过生成大量训练数据并对基础模型进行微调,来创建一个强大的指令跟随模型。

Comments | NOTHING